Ollama

0.参考文章

💻 handy-ollama 🦙(动手学 Ollama 教程)

1. 下载安装

https://ollama.com/download/windows

2. 部署模型

ollama run deepseek-r1:1.5b

3. 常用配置

| 环境变量 名 | 环境变量 值 | 注释 |

|---|---|---|

| OLLAMA_HOST | http://0.0.0.0:11434 | 监听端口 |

| HTTP_PROXY | 代理 | |

| HTTPS_PROXY | 代理 | |

| OLLAMA_MODELS | C:\Users\%username%.ollama\models | 模型存储目录 |

4. 调用

openai => http://localhost:11434/v1

5. 接入案例

- WPeChatGPT

修改后的代码 WPeChatGPT-2.5.7z

解压到

IDA/plugins/使用前请先到ida的python3下安装依赖

pip install -r ./requirements.txt

-

ChatGPT-Next-Web

https://docs.nextchat.dev/models/ollama

vercel 添加变量

OLLAMA_ORIGINS=*://localhost(亲测还是跨域,建议直接使用客户端,不用Web端)

| 设置名 | 值 | 备注 |

|---|---|---|

| 自定义接口 | true | |

| 模型服务商 | OpenAI | |

| 接口地址 | http://localhost:11434/ | |

| 自定义模型名 | deepseek-r1:32b,deepseek-r1:7b | 根据本地Ollama装了啥填写 |

-

Open-Webui

https://github.com/open-webui/open-webui?tab=readme-ov-file#how-to-install-

pip install open-webui open-webui serve访问 http://localhost:8080/ 开始,左上角显示所有本地已安装Ollama的模型

-

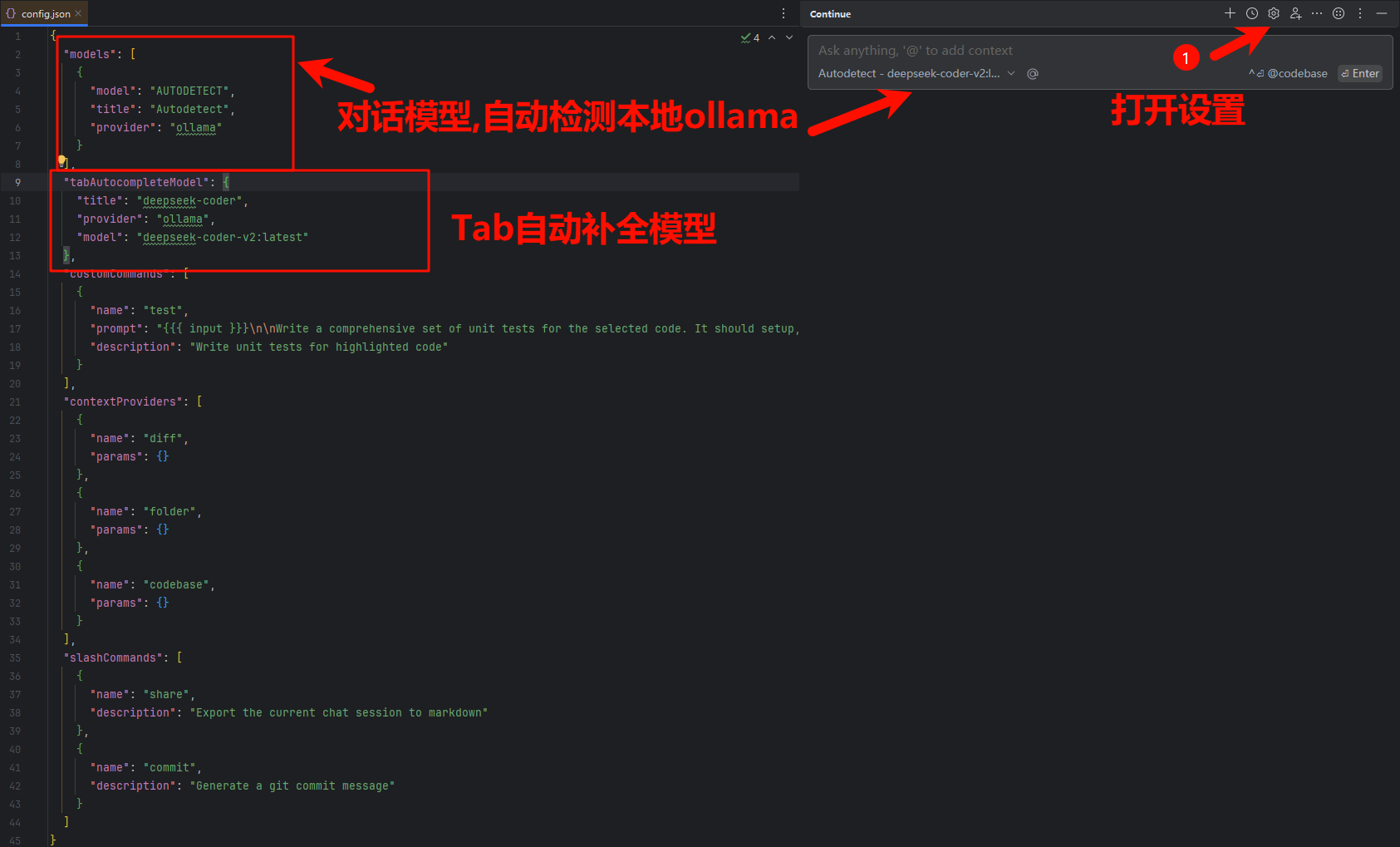

Continue

使用配置

"models": [ { "model": "AUTODETECT", "title": "Autodetect", "provider": "ollama" } ], "tabAutocompleteModel": { "title": "deepseek-coder", "provider": "ollama", "model": "deepseek-coder-v2:latest" }自动补全的模型建议用coder版本,而且不要太大,避免反应过慢

Dify

https://github.com/langgenius/dify

https://docs.dify.ai/zh-hans/getting-started/install-self-hosted/docker-compose

配置代理

cd dify/docker/ssrf_proxy

# cp squid.conf.template squid.conf

# 上游代理

cache_peer 172.26.176.5 parent 7890 0 no-query default

# 重启

docker compose down

docker compose up -d

ida-pro-mcp

https://github.com/mrexodia/ida-pro-mcp

建议IDA_PRO_9.0

ida_py目录下

cd ./Scripts

.\pip install --upgrade git+https://github.com/mrexodia/ida-pro-mcp

ida-pro-mcp --install

# C:\Users\QL\.cursor\mcp.json 复制json内容到MCP客户端添加

# ida打开项目 左上角工具栏 `Edit -> Plugins -> MCP` 启动服务